Améliorer le référencement naturel d’un site Internet n’est pas une chose simple. Il ne suffit pas de faire quelques optimisations au moment de sa conception et d’attendre pour que vous soyez bien classés dans les résultats des moteurs de recherche tel que Google, Bing ou Yahoo.

Il existe une multitude de critères pris en compte pour positionner votre site dans une recherche Google. Et il existe autant de raisons pour lesquelles un internaute ne vous trouve pas en effectuant une recherche.

Une fois que l’on a fait le constat d’un manque de performances, il convient de ne pas foncer tête baissée et de réfléchir à la meilleure stratégie à mettre en œuvre pour corriger cela.

Il faut s’appuyer sur l’ensemble des données à disposition (statistiques, positionnement…) et sur une méthode logique pour réussir à améliorer son SEO (Search Engine Optimization).

Dans cet article, je vous livre une méthode et des astuces utilisées en agence pour mieux comprendre quelles sont les points à travailler pour améliorer le référencement de votre site.

L’analyse des performances du site Internet

La première étape de notre travail va consister à faire en quelque sorte un « état des lieux » des performances de votre site sur les moteurs de recherche. Cela permettra de savoir où vous vous situez (notamment par rapport aux concurrents) et quel est la marge de progression possible de la solution déjà en place.

Pour cela, il faut d’abord faire un point sur les données que nous possédons :

- Un outil de mesure statistiques comme Google Analytics est-il installé ?

- Le site a-t-il été relié à l’outil pour webmaster Google Search Console ?

- Est-ce que des données de suivi de performances comme le positionnement dans les résultats Google ou les conversions sont disponibles ?

Il est important de disposer de ces données et sur une durée la plus longue possible. Elles nous permettront de mesurer concrètement ce qui marche et ce qui ne marche pas sur votre site web.

Analyser le positionnement sur Google

La première étape consiste à vérifier comment votre site web se positionne sur Google lorsque les internautes effectuent des recherches en rapport avec votre activité. Il faut bien savoir d’où l’on part pour savoir où l’on veut arriver.

La question est simple : est-ce que votre site est correctement classé sur les mots-clés liés à votre activité ?

Pour cela vous pouvez opter pour une vérification manuelle en effectuant les recherches vous-même mais cela est déconseillé. En effet en fonction de votre localisation, du support que vous utilisez ou de la présence ou non d’un compte Google lors d’une recherche, vous pouvez obtenir des résultats différents et qui ne reflètent pas la réalité.

Il est ainsi préférable de passer par un outil de suivi de positionnement spécialisé et qui vous donnera des résultats réels.

L’avantage, c’est que celui-ci peut simuler toutes les situations : recherche géolocalisées, dans différents pays, supports…

Les données ainsi obtenues pourront éventuellement être croisées avec celles de Google Search Console (que nous allons voir un peu plus loin) après export en fichier Excel. Cela pourra également servir de concevoir un tableau avec un suivi au fil des semaines.

Analyser les statistiques

La collecte de données statistiques sur vos visiteurs est primordiale. Comment savoir si votre site web est apprécié par ces derniers si vous ne savez même pas ce qu’ils font dessus ?

Google Analytics va ainsi nous fournir des informations tel que :

- Le nombre de visiteurs. Cette donnée permet de mesurer si votre site est plus ou moins visité au fil du temps.

- Le taux de rebond. Cela nous indique si vos visiteurs sont restés sur votre site où s’ils l’ont rapidement quitté. Un taux élevé est révélateur d’un problème (technique, performances, contenus…) qu’il faut corriger.

- La durée de session, c’est à dire combien de temps en moyenne vos visiteurs passent sur votre site web.

- Le nombre de pages vues par session, soit combien de pages les utilisateurs parcourent en une fois (moyenne).

Bien sûr je ne réduis pas Analytics à ces seules données qui ne sont que des exemples. C’est une mine d’or d’informations. On peut également y retrouver les supports utilisés (smartphone, tablette…), les systèmes d’exploitation utilisés, la localisation des visiteurs, les pages visitées (blog, contact, références…), par quel biais ils arrivent sur votre site….

Quoi qu’il en soit et sans être un expert de la plateforme, on peut tout de même rapidement tirer des conclusions lorsque l’on analyse les chiffres.

Dans l’exemple ci-dessous, on peut constater que le site a un taux de rebond de près de 75% et une durée moyenne de sessions de 44 secondes. Cela signifie clairement que 3/4 des utilisateurs quittent le site au bout de quelques secondes et que les autres ne restent pas longtemps.

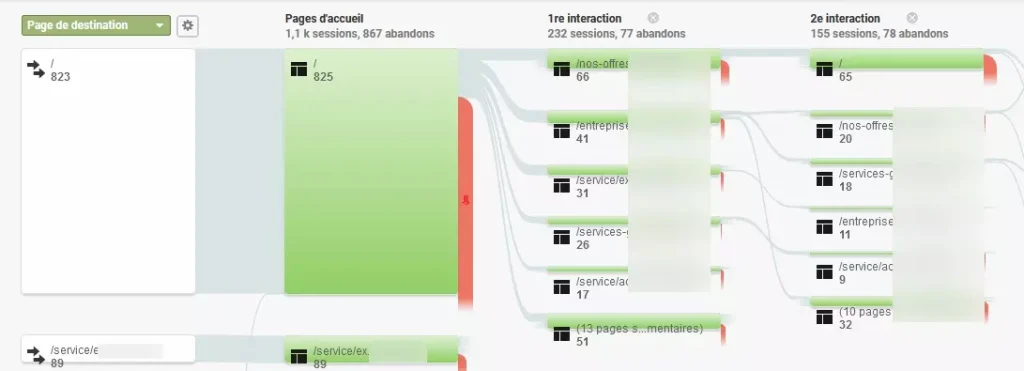

Continuons avec le même site et passons sur le flux de comportement (disponible dans COMPORTEMENT -> FLUX DE COMPORTEMENT), qui nous offre une interface assez visuelle et qui nous permet de comprendre comment les internautes naviguent sur le site et à partir de quelle page ils le quittent.

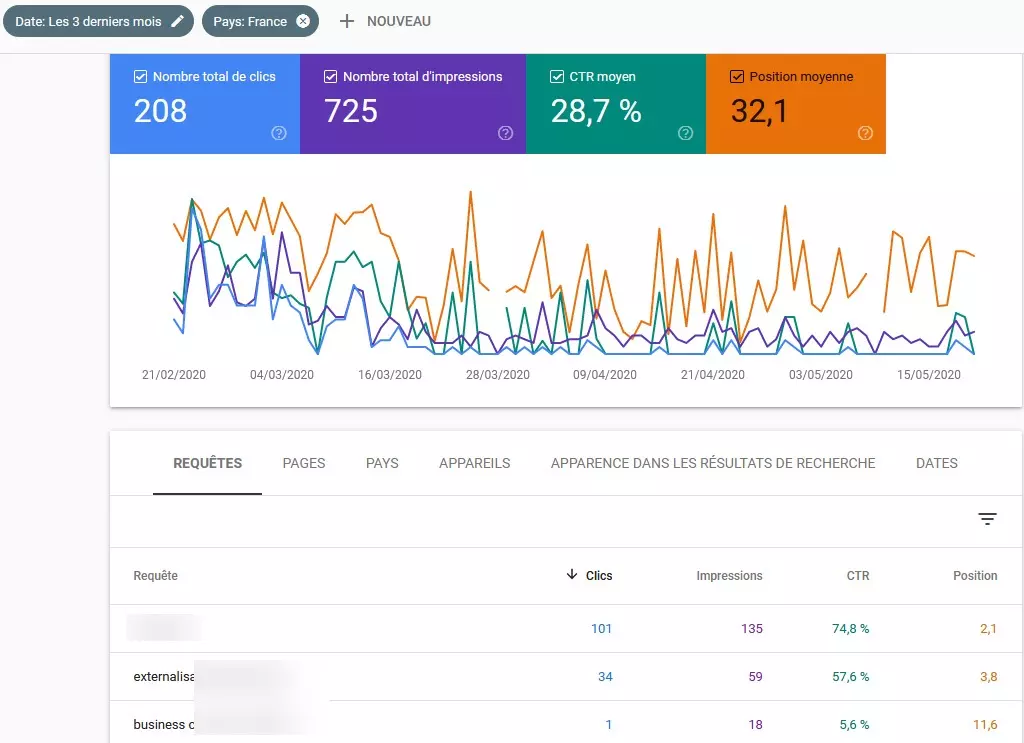

Google Search Console, la plateforme pour webmaster de Google est également une source intéressante de données puisqu’elle nous fournit des données sur les performances SEO de votre site sur le moteur de recherche.

Vous pouvez ainsi savoir :

- Quels mots-clés ont déclenchés un affichage de votre site (impression) dans les résultats et quels sont ceux qui ont déclenchés des visites sur votre site (clics).

- Votre positionnement moyen sur le mot-clé concerné (pour rappel, Google affiche généralement 10 résultats par page).

- Le taux de clic, c’est à dire le pourcentage d’internautes ayant cliqué sur le lien menant vers votre site lorsque celui-ci apparaissant dans les résultats de Google.

Afin d’obtenir des données pertinentes, je vous recommande d’ailleurs de filtrer les données en sélectionnant le pays (ici la France). Avez-vous réellement besoin de savoir ce que font vos visiteurs russes si votre clientèle est intégralement française ?

Vous pouvez appliquer d’autres filtres pour trier les données. Par exemple en ne sélectionnant que celles provenant des visiteurs utilisant un support mobile.

Vous l’aurez compris, ces données sont importantes car elles nous indiquent par exemple si les requêtes sur lesquelles se positionnent votre site correspondent à ce que vous souhaitiez cibler ou du moins est-ce qu’elles correspondent aux services ou produits que vous proposez.

Analyser l’environnement technique

Il existe de multiples solutions pour créer un site et les solutions pour l’héberger ne manque pas non plus. Pourtant ce contexte technique est essentiel car il déterminera quelles actions pourront être réalisées et de quelles manières.

- Comment votre site a-t-il été conçu ?

- Sur quel type d’hébergement se trouve votre site et comment est-il configuré ?

Ainsi si vous possédez un site conçu sur WIX ou une plateforme équivalente, vous aurez du mal à obtenir de bons résultats car les possibilités sont limitées.

De la même manière si vous possédez un site dit « statique », la manière dont vous pourrez travailler votre référencement ne sera pas la même que si ce dernier a été conçu sur une plateforme CMS tel que WordPress, car le site statique nécessitera des compétences techniques supplémentaires.

Il en est de même pour l’hébergement. Un hébergement de mauvaise qualité peut impacter votre site en termes de référencement, de vitesse de chargement ou même de sécurité. Il faut donc vérifier si celui-ci est correctement dimensionné par rapport à vos besoins (mutualisé, VPS, serveur dédié…) et que toutes les bonnes pratiques en matière de configuration ont bien été mises en place.

L’analyse de l’environnement technique permettra enfin d’anticiper de futurs problèmes lorsqu’il s’agira d’intervenir sur votre site, par exemple si votre site web a besoin d’une configuration spécifique et que votre hébergeur ne peut pas la supporter.

L’audit du site web

Nous avons dans l’étape précédente collecté des données pour connaître le niveau de performances de votre site web.

Ces données serviront par la suite lorsqu’il s’agira de mesurer l’efficacité et l’impact des actions qui auront été menées pour améliorer votre référencement :

- Évolution du positionnement (en bien ou en moins bien).

- Hausse du trafic.

- Baisse du taux de rebond, augmentation des conversions…

Et maintenant que cela vous a permis de voir que celles-ci ne sont pas satisfaisantes, il faut procéder à un audit complet de votre site web afin d’identifier les problèmes qui empêche justement votre site d’être performant.

Nous allons pour cela travailler autour de 3 critères principaux : la technique, le contenu et la popularité, 3 piliers connus du référencement.

L’audit technique

La technique est un élément fondamental à prendre en compte en termes de référencement pour tous les sites.

Il existe de multiples bonnes pratiques et recommandations et à respecter afin que le robot de Google soit efficace lorsqu’il vient parcourir votre site, c’est à dire qu’il se concentre sur le contenu optimisé et qu’il puisse parcourir le site sans difficultés.

Par exemple, certaines pages de votre site sont indispensables : mentions légales, politique de confidentialité… Mais elles sont clairement inutiles en termes de référencement. Il est donc possible d’indiquer à Google qu’il est inutile d’afficher ces pages dans son index.

Pour réaliser un audit technique complet, nous allons avoir besoin de plusieurs outils parmi lesquels :

- Un crawler, c’est à dire un programme qui se comporte comme le ferait le robot d’un moteur de recherche

- Un logiciel qui nous permettra d’analyser les journaux d’accès (log) du serveur pour justement voir comment le robot se comporte lorsqu’il visite votre site.

Parmi les critères techniques qu’il convient de respecter pour optimiser les pages web de son site en termes de référencement, la présence et l’optimisation de certaines balises est essentiel.

Saviez-vous par exemple que vous pouviez personnaliser le titre et le texte descriptif de chaque page de votre site sur un moteur de recherche ?

Pour cela, vous pouvez choisir quel texte s’affichera dans :

- La balise title (ou titre), illustré ci-dessous en bleu

- La balise meta description (ou descriptif de la page), illustré ci-dessous en rouge

Il s’agit ici de placer les éléments stratégiques (mots-clés, arguments commerciaux), tout en respectant une longueur maximale.

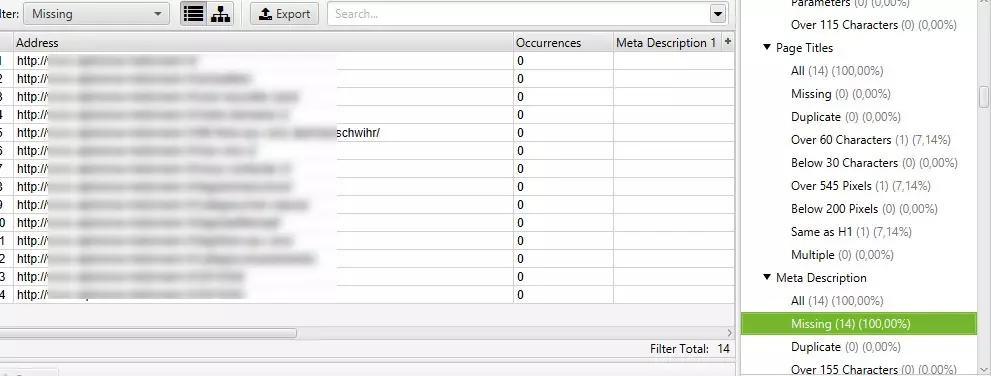

Le rôle du crawler sera justement d’identifier (entre autres) des problèmes d’optimisations de ces balises titre et description sur votre site :

Sur l’exemple ci-dessous, on peut par exemple voir que le programme a détecté une erreur : aucune balise meta description n’est renseignée sur 14 pages du site utilisé dans notre exemple.

Le crawler était un programme complet, il permet donc de détecter d’autres problèmes tels que des soucis d’optimisation d’images, des problèmes de performances, des erreurs dans le fichier robots txt ou encore de maillage interne (comment sont reliés les pages de votre site entre elles).

Il faut donc rassembler dans un document toutes les erreurs détectées afin de les corriger, en priorisant sur celles ayant le plus d’impact.

Une fois que cela fait, nous pouvons passez à l’analyse de logs. Cette étape permet de mieux comprendre comment les moteurs de recherche se comportent lorsqu’ils viennent visiter votre site.

On pourra grâce à cela détecter des erreurs auxquels ils sont confrontés afin de les éliminer et d’améliorer le processus de crawl.

Ici on peut facilement voir que le bot est parfois confronté à une erreur 404, c’est à dire une url introuvable. C’est un mauvais signal envoyé au robot et cela peut handicaper la manière dont celui-ci indexera votre site.

L’analyse de log offre d’autres informations intéressantes comme la liste des pages que le robot de Google visite le plus, celles qu’au contraire il ne visite pas ou peu. Cela peut révéler des problèmes d’optimisation ou de maillage entre les pages.

Vous l’aurez compris, la combinaison entre ces deux analyses (technique et logs) nous fournit de précieuses informations sur toutes les problématiques qui peuvent expliquer un mauvais classement dans les résultats Google.

Notez cependant que d’autres critères d’ordre technique peuvent être analysés en complément, comme par exemple la compatibilité mobile de votre site, c’est-à-dire un fonctionnement optimal sur tous les supports (smartphones, tablettes…)

Search Console peut également vous signaler des points d’amélioration : erreurs d’ergonomie, de sécurité…

L’audit de contenu

« Content is king ». C’est une des maximes favorites de Google en ce qui concerne le SEO. Il est assez clair que le contenu rédactionnel d’un site Internet est essentiel pour le moteur de recherche. Comment ferait-il pour savoir sur quelles requêtes positionner votre site Internet sans contenu ?

Votre contenu doit donc être optimisé afin de permettre à Google d’interpréter le « sujet » de votre page et de vous positionner sur les mots-clés associés.

Il existe plusieurs critères à prendre en compte pour cela et notamment

- La longueur du contenu.

- La qualité éditoriale du contenu.

- La présence de médias (images, vidéos)

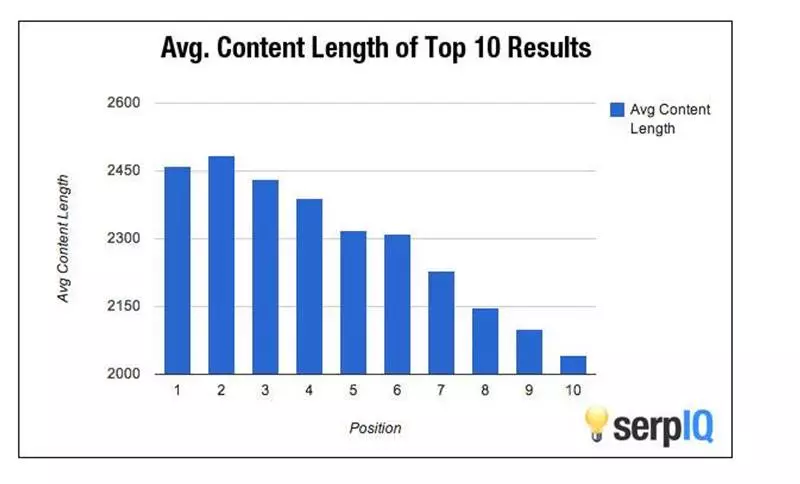

Il est communément admis qu’une page doit disposer d’au moins 400 mots pour avoir une chance de se positionner. Des études ont également révélé que sur la première page de Google, les contenus plus longs se positionner mieux.

Mais cela ne veut pas dire que vous devez à tout prix écrire 2500 mots sur chaque page de votre site. D’abord parce que si pour y parvenir vous « tartinez », cela sera contreproductif car votre contenu sera jugé de mauvaise qualité. Ensuite parce que selon votre secteur d’activité, la concurrence et les requêtes concernées, il suffira peut-être d’écrire 800 mots pour atteindre les premières places.

Vous devez donc veiller à produire un contenu d’une longueur minimum, structuré et varié, en employant le vocabulaire et les termes appropriés.

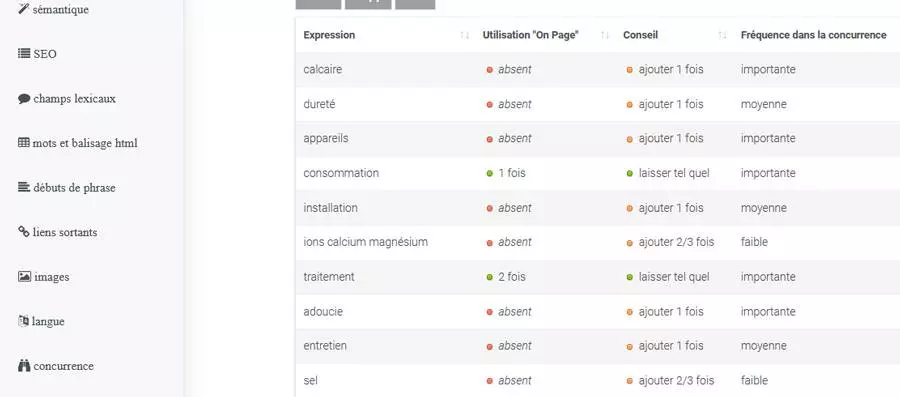

Mais avant d’éventuellement améliorer votre contenu, il faut d’abord connaitre le niveau actuel d’optimisation de celui-ci.

Pour cela différents outils vous permettent de contrôler ce point. Ces derniers seront en mesure de vous donner des conseils et de vous indiquer si votre page contient suffisamment de texte, si l’url est correctement optimisée pour votre mot-clé cible, si votre contenu emploie les bons termes…

Liens entrants et popularité

Troisième et dernière étape de notre audit de site web, les liens entrants (ou backlinks) et la « popularité » de votre site.

Ces critères SEO, contrairement à ce que nous avons vu jusqu’ici, ne sont pas liés à la manière dont le site est conçu. Ce sont des critères dit OFF PAGE ou OFF SITE , extérieurs pour faire simple.

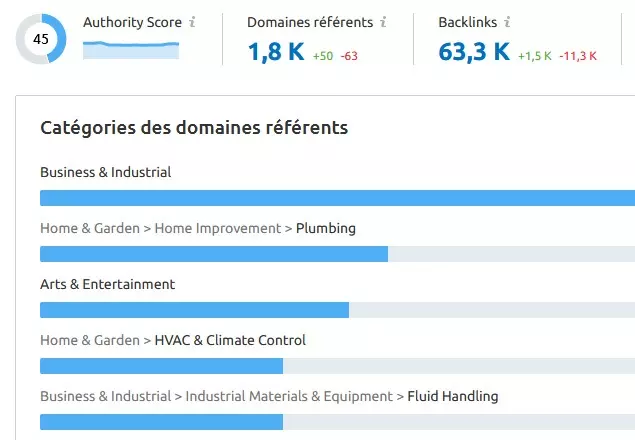

Lorsqu’un site Internet fait un lien vers le vôtre, l’algorithme de Google en tient compte pour vous positionner. Ces liens (notamment) vont vous apporter ce qu’on appelle une autorité de domaine.

Pour schématiser, il s’agit d’un score de 0 à 100 et qui exprime la confiance que Google accorde à votre site Web. Un score d’autorité plus élevé jouera à coup sûr sur votre positionnement dans les résultats.

Pour cela Google utilise la quantité mais aussi (et surtout) la qualité des liens qui sont effectuées. Plus vous posséderez de liens de bonne qualité mieux ce sera.

Il existe différentes possibilités pour acquérir de nouveaux backlinks : échange de liens contrôlé, articles invités, article sponsorisé…

Mais avant de faire quoi que ce soit et comme pour le reste, nous devons d’abord contrôler où votre site web se situe par rapport à ces critères.

Pour cela vous pouvez opter pour des outils tels que Majestic SEO ou SEMRush.

Ce dernier nous offre à travers une interface dédiée ce que nous souhaitons : la liste des liens entrants pour un site Internet donné ainsi que son score d’autorité :

Il convient ici d’étudier en détails la liste des sites Internet qui font lien vers votre site et surtout la qualité de ces derniers. Cela permettra de déterminer s’il est nécessaire d’améliorer ce point en procédant à une campagne de netlinking (acquisition de liens).

Analyse de la concurrence

Maintenant que vous êtes en pleine connaissance de votre situation et des problématiques qui entourent votre site Internet, il s’agit de regarder comment vos concurrents travaillent le SEO de leur site Internet.

En effet, vos concurrents sont probablement devant vous parce que votre site web a besoin d’améliorations mais peut-être aussi parce qu’ils ont mis en place une stratégie plus efficace pour atteindre les premières places du classement de Google.

Il s’agit donc d’analyser leurs sites web, de découvrir des astuces pour optimiser votre référencement et de voir comment se situent vos concurrents par rapport à vous. Vous pourrez ainsi concevoir votre propre stratégie en vous basant sur l’ensemble de vos concurrents.

Par exemple, peut-être allez-vous découvrir lors de votre étude que la plupart de vos concurrents possèdent sur leur site un blog où ils postent régulièrement des articles thématiques que cette section représente un pourcentage intéressant de leur trafic.

Cela peut au passage vous donner des idées de contenu.

L’analyse concurrentielle doit permettre de répondre aux questions suivantes :

- Quelles sont mes concurrents ? (Attention, ce ne sont pas forcément les mêmes sur Google et en physique)

- Comment se placent-il sur des requêtes associées à mon activité ?

- Quels sont les critères de référencement naturel que vos concurrents ont travaillés en priorité ?

Pour obtenir les bonnes réponses, il existe de multiples outils dont l’excellent SEMRush. Ce dernier, via son outil analyse de domaine, va nous fournir tout ce dont nous avons besoin :

- Estimation du trafic.

- Mots-clés sur lesquels le site concurrent se positionne.

- Affichage des annonces si celui-ci fait du référencement payant avec Google Ads (ex Google Adwords).

- La liste des liens entrants (backlinks) dont le site dispose.

- …

Toutes ces informations pourront être exportées sous forme de fichier (CSV, Excel…) pour être traité ensuite.

Par ailleurs, n’hésitez pas à utiliser les outils d’audit sur le site web de votre concurrent. Cela vous permettra de voir comment ce dernier a travaillé plus particulièrement certains critères : le contenu, la technique…

Construire un rapport

Si vous avez respecté la méthode décrite depuis le début, vous devez maintenant disposer de suffisamment d’informations pour prendre les bonnes décisions pour optimiser le référencement naturel de votre site web.

Vous avez normalement en votre possession :

- Le niveau de performances de votre site Internet après analyse des statistiques et du suivi de positionnement.

- Tous les points qu’il est nécessaire de corriger / améliorer pour votre site Internet grâce à un audit complet du site web.

- Des informations sur le niveau de performances de vos concurrents et sur les stratégies mises en place par ces derniers pour améliorer leur référencement naturel Google.

Il vous reste donc à agréger ces informations dans un rapport structuré en chapitres. Cette étape est un point clé, destinée à trier et synthétiser le flot de données dont vous disposez.

Si vous ne le faites pas, vous risquez de ne pas prendre les mauvaises décisions en passant à côté de certains points. Il ne s’agit pas d’accumuler beaucoup de données, il faut pouvoir les traiter pour les interpréter correctement.

Si vous n’avez pas la possibilité de le faire, vous pouvez faire appel à une agence web qui pourra se charger de procéder à l’audit et à l’analyse de votre site web et au traitement des données sous forme de rapport. Elle pourra également vous fournir des conseils avisés pour réussir votre projet.

Une fois que vous disposerez de ce dernier, vous aurez toutes les clés en main pour établir une véritable tactique et un plan des actions à mener par ordre de priorité.

Et après ?

Lorsque votre plan d’action aura été mis en œuvre et que tous les points d’améliorations auront été travaillés, il est logique et nécessaire de voir si cela a eu l’effet escompté et que votre site web est désormais en bonne place dans les résultats des moteurs de recherche.

Pour cela vous pouvez utiliser certains des outils cités dans cet article pour suivre les performances de ce dernier.

Vous pourrez ainsi effectuer des comparaisons entre les deux périodes avant/après et constater la réussite de votre stratégie.